LM Studio: 내 PC에서 AI 언어모델을 자유롭게 실행하는 방법

안녕하세요, 쌍팔년생 개발자입니다.

작년에 저희 팀에서 ChatGPT API를 사용하는 프로젝트를 진행하면서 정말 고민이 많았어요. API 비용이 생각보다 훨씬 많이 나오는 거예요... 😰 특히 개발 단계에서 테스트하다 보니 월 비용이 감당하기 어려운 수준까지 올라갔죠.

그런데 더 큰 문제는 보안이었어요. 고객 데이터를 외부 API로 전송하는 것에 대해 팀 내에서도 우려의 목소리가 나왔거든요. "이거 정말 안전한 걸까?"라는 의문이 계속 들었습니다.

그러던 중 Hacker News에서 흥미로운 글을 발견했어요. "LM Studio라는 도구로 로컬에서 AI 모델을 돌릴 수 있다"는 내용이었는데, 처음에는 "내 노트북에서 AI가 돌아간다고?"라며 반신반의했는데...

TL;DR: LM Studio는 내 PC에서 오프라인으로 AI 언어모델을 실행할 수 있는 사용자 친화적인 데스크탑 앱입니다. 개인정보 보호와 비용 절약을 동시에 해결하며, 복잡한 설정 없이 다양한 오픈소스 AI 모델을 쉽게 체험할 수 있습니다.

실제로 사용해보니 저희가 고민하던 비용과 보안 문제를 정말 깔끔하게 해결해주더라고요. 이 글에서는 그때의 경험을 바탕으로 LM Studio가 무엇인지, 어떻게 활용할 수 있는지 공유해드리려고 해요.

저희가 겪었던 AI API의 딜레마

1. 예상치 못한 비용 폭탄

처음에는 "API 비용이 얼마나 나올까?"라고 생각했는데, 실제로는 상상을 초월했어요. 개발 중에 반복적으로 테스트하다 보니 하루에 수십 달러씩 나가더라고요.

팀장님이 "이 속도로 가면 예산 초과할 것 같은데..."라고 하시는 순간, 정말 머리가 하얘졌어요. 프로토타입 단계에서부터 이런 비용이면 실제 서비스는 어떻게 운영하지?

2. 보안과 개인정보 우려

더 큰 고민은 보안이었어요. 고객 데이터를 외부 API로 전송해도 되는 건지 팀 내에서 계속 논의가 있었거든요.

특히 시니어 개발자분이 "GDPR이나 개인정보보호법 관점에서 봤을 때 위험할 수 있어"라고 하시면서, 대안을 찾아야 한다는 의견이 나왔어요.

3. 의존성의 부담

인터넷이 끊기거나 API 서버에 문제가 생기면 저희 서비스도 함께 멈춰버린다는 점도 부담이었어요. "이렇게 외부 서비스에 의존해도 될까?"라는 고민이 계속 들었습니다.

LM Studio와의 첫 만남

동료의 추천

그때 저희 팀의 AI에 관심이 많은 동료분이 "LM Studio라는 걸 찾았는데, 로컬에서 AI 모델을 돌릴 수 있다고 해요"라고 알려주셨어요.

처음에는 "진짜? 내 노트북에서 ChatGPT 같은 모델이 돌아간다고?"라며 믿기지 않았죠. "성능이 얼마나 나올까?"라는 의구심도 있었고요.

첫 설치와 실험

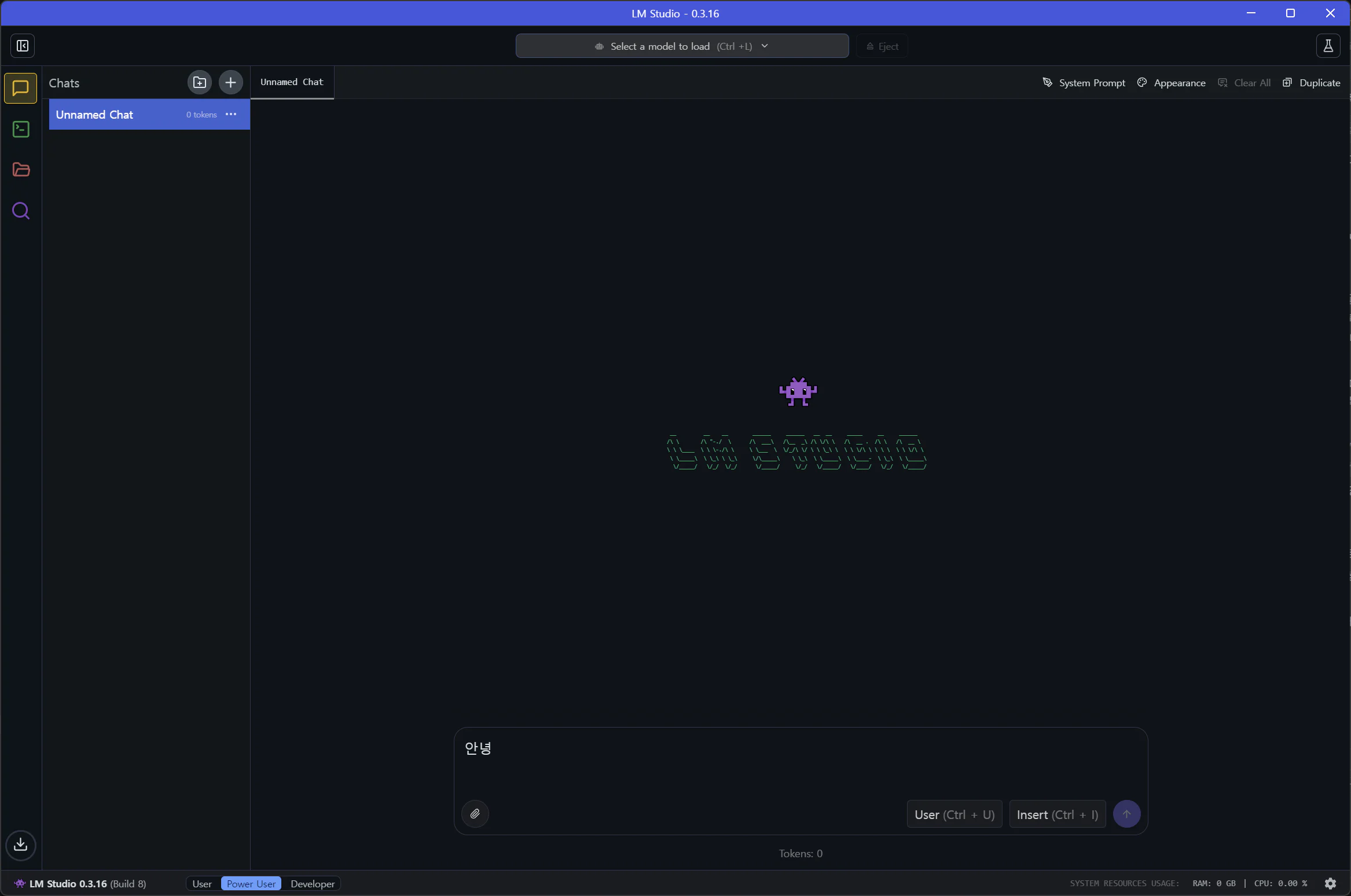

LM Studio는 생각보다 설치가 간단했어요. lmstudio.ai에서 다운로드받아서 그냥 일반 프로그램처럼 설치하면 끝이더라고요.

처음 실행했을 때 "이게 정말 AI 모델을 다운로드하는 프로그램이 맞나?"라는 생각이 들 정도로 깔끔하고 직관적인 인터페이스였어요.

첫 번째 모델 다운로드

동료분 조언에 따라 Llama 2 7B 모델부터 시작해봤어요. "처음에는 작은 걸로 테스트해보세요"라고 하시더라고요.

다운로드하는 동안 "정말 이게 될까?"라는 반신반의한 마음이었는데...

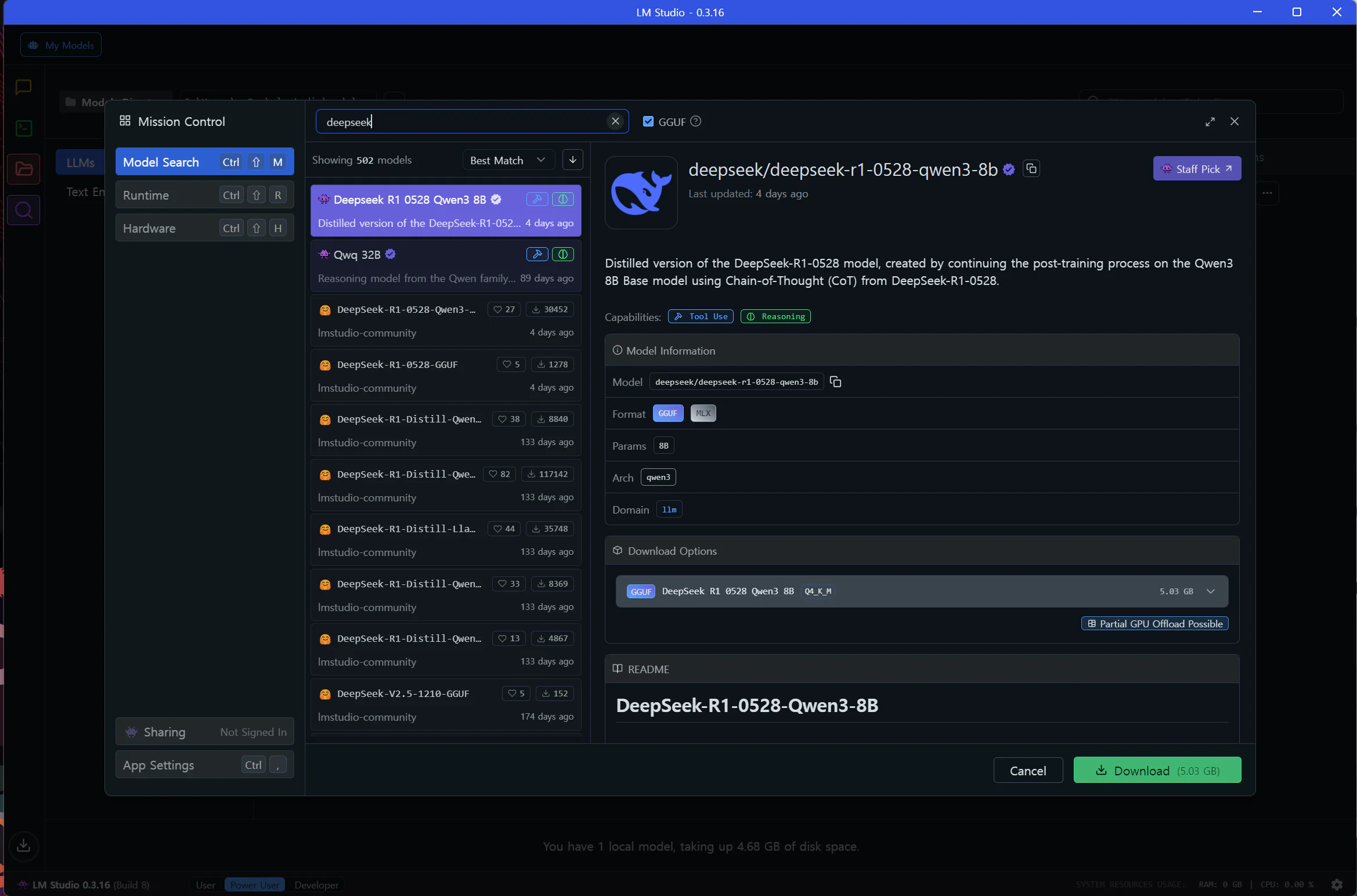

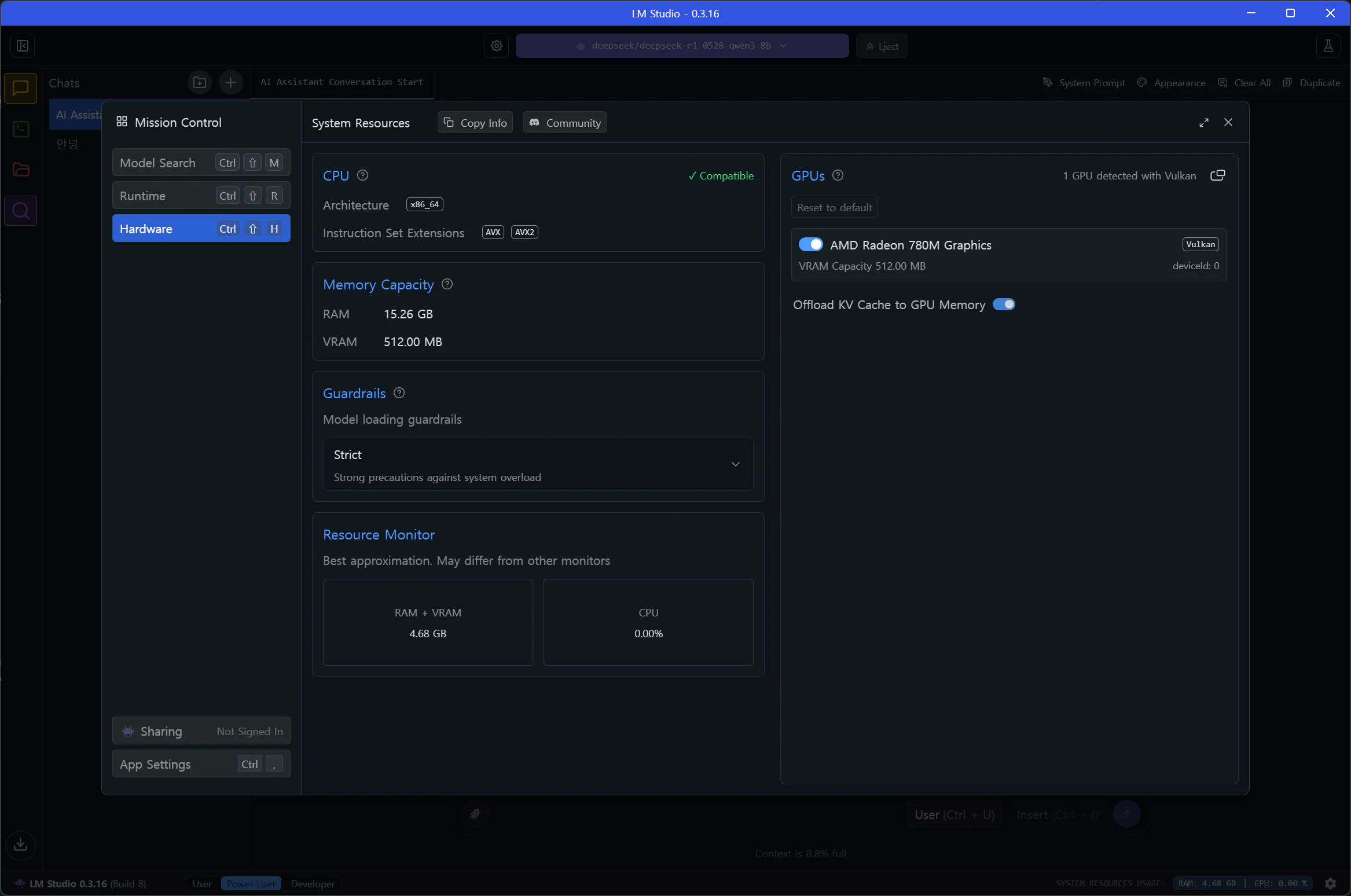

사용하는 시스템의 비디오 메모리에 따라 실행할 수 있는 모델의 용량이 제한됩니다. 모델을 다운로드하기 전에 시스템의 VRAM을 먼저 확인하세요.

실제 테스트 결과와 놀라운 발견

첫 번째 테스트: 기대 반 걱정 반

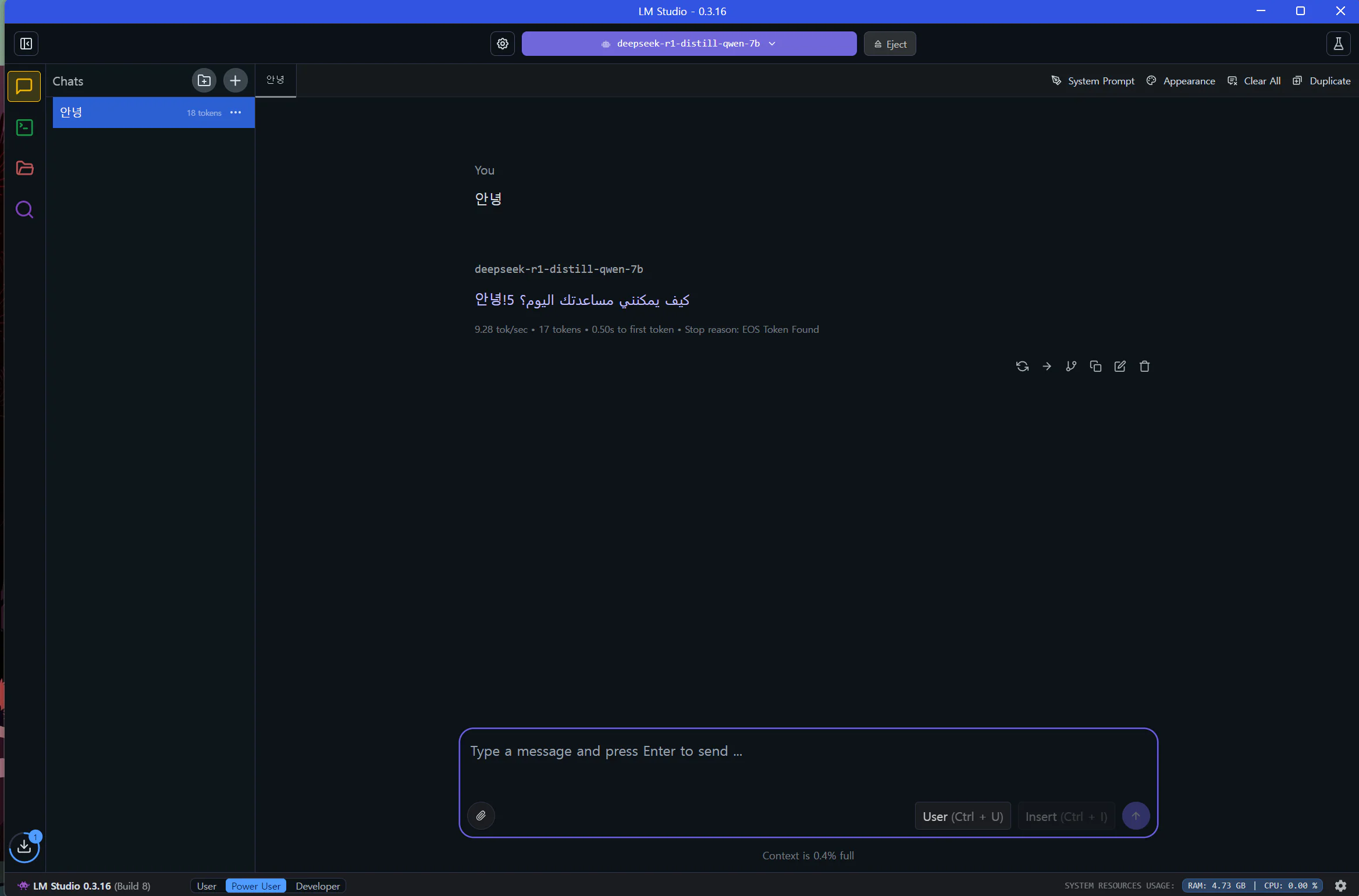

4.68GB 크기의 DeepSeek R1-distill-qwen-7b 모델로 첫 테스트를 진행했어요.

한국어로 "안녕"을 입력했더니... 응답이 좀 이상하더라고요. 한국어 "안녕!"과 함께 알 수 없는 문자가 나왔어요. "역시 로컬 모델은 한계가 있나?"라는 생각이 들었죠.

두 번째 시도: 더 나은 모델로

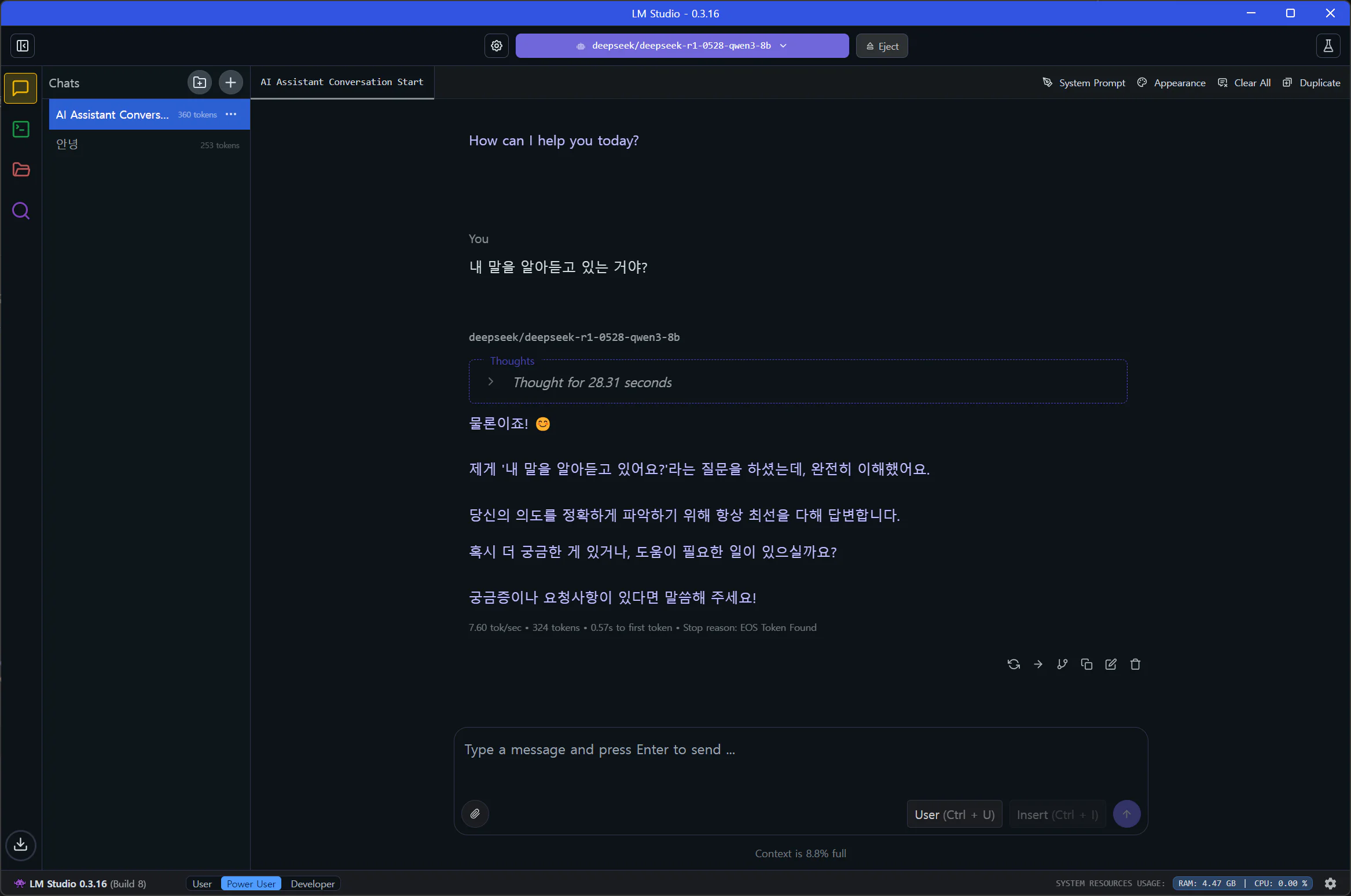

포기하지 않고 동료분과 함께 더 최신 버전인 DeepSeek R1-0528 모델을 시도해봤어요.

이번에는 정말 깜짝 놀랐어요! 간단한 질문에 28.31초가 걸렸지만, 정상적인 한글 문장으로 답변이 나왔거든요. "와, 진짜 내 노트북에서 AI가 답변을 만들어냈다!"

속도는 아쉬웠지만, 오프라인 환경에서 로컬 노트북이 AI 답변을 생성한다는 점이 정말 신기했어요.

저희 테스트 환경의 한계

저희가 테스트한 노트북은 100만원대의 평범한 AMD CPU 계열 내장그래픽이었어요. VRAM이 512MB에 불과해서 성능에 한계가 있었죠.

하지만 팀원 중에 고성능 그래픽카드를 가진 분이 테스트해보니 훨씬 빠른 속도로 동작하더라고요. "이정도면 실제로 활용할 수 있겠는데?"라는 생각이 들었어요.

LM Studio의 핵심 장점들

🔒 완벽한 개인정보 보호

가장 마음에 든 점은 모든 데이터가 내 컴퓨터에서만 처리된다는 거예요. 더 이상 고객 데이터를 외부로 전송할 걱정이 없어졌죠.

팀장님도 "이거면 보안 승인받기 훨씬 쉬울 것 같은데"라고 하시면서 긍정적으로 반응해주셨어요.

💰 비용 걱정 제로

초기 모델 다운로드 후에는 추가 비용이 전혀 발생하지 않아요. "API 비용 걱정 없이 마음껏 테스트할 수 있겠네"라는 생각에 정말 홀가분했어요.

🌐 인터넷 독립성

모델을 한번 다운로드하면 인터넷이 끊어져도 사용할 수 있어요. "이제 외부 서비스 의존성 걱정은 없겠구나"라는 안도감이 들었죠.

🎨 개발자 친화적 인터페이스

복잡한 설정 없이도 OpenAI API와 호환되는 로컬 서버를 제공해요. 기존 코드를 거의 수정하지 않고도 연동할 수 있더라고요.

시스템 요구사항과 현실적 고려사항

최소 사양과 권장 사양

실제 사용해본 결과 공식 권장사항은 다음과 같아요:

최소 사양:

- macOS: M1/M2/M3 칩, macOS 13.6 이상

- Windows/Linux: AVX2 지원 CPU, 8GB RAM, 4GB 이상 VRAM

권장 사양:

- RAM: 16GB 이상 (큰 모델의 경우 32GB 권장)

- GPU: NVIDIA RTX 시리즈 또는 Apple Silicon 칩

- 저장공간: 모델 크기에 따라 10GB~100GB 이상

저희 경험상 성능이 좋을수록 응답 시간이 확실히 단축되더라고요.

저희 팀의 활용 사례

💻 프로토타입 개발

API 비용 걱정 없이 마음껏 테스트할 수 있어서 프로토타입 개발이 훨씬 수월해졌어요. "이제 아이디어 검증을 자유롭게 할 수 있겠다"는 생각이 들었어요.

📝 문서 작성 도움

기술 문서나 코드 주석 작성할 때 로컬 AI의 도움을 받고 있어요. 인터넷 없는 환경에서도 활용할 수 있어서 편리하더라고요.

🔍 코드 리뷰 보조

CodeLlama 모델을 사용해서 코드 리뷰나 버그 찾기에도 활용하고 있어요. 완벽하지는 않지만 보조 도구로는 충분히 유용해요.

다른 도구들과의 비교

동료분과 함께 Ollama도 함께 비교해봤어요:

| 특징 | LM Studio | Ollama |

|---|---|---|

| 인터페이스 | 그래픽(GUI) | 명령줄(CLI) |

| 사용 편의성 | 초보자도 쉽게 사용 | 개발자 중심 |

| 모델 관리 | 클릭으로 간편하게 | 명령어로 관리 |

저희는 GUI를 선호해서 LM Studio가 더 맞았어요. 하지만 CLI를 좋아하는 팀원은 Ollama를 더 선호하더라고요.

성능 최적화 팁과 노하우

하드웨어 최적화

실제 사용하면서 터득한 팁들이에요:

- GPU 가속 활용: NVIDIA 그래픽카드가 있다면 CUDA 가속을 꼭 활성화하세요

- 메모리 관리: 다른 프로그램들을 종료하고 사용하면 성능이 확실히 좋아져요

- SSD 사용: 모델 로딩 시간이 확실히 단축됩니다

모델 선택 전략

팀에서 정한 모델 선택 기준이에요:

- 7B 모델부터 시작: 처음에는 작은 모델로 테스트

- 양자화 모델 활용: Q4_K_M 같은 양자화 모델로 메모리 절약

- 용도별 모델: 코딩, 채팅, 번역 등 목적에 맞게 선택

주의사항과 한계점

라이선스 확인의 중요성

상업적 용도로 사용할 경우 각 모델의 라이선스를 반드시 확인하세요. 일부 모델은 상업적 사용이 제한될 수 있습니다.

팀에서 상업적 사용을 고려할 때 라이선스를 꼼꼼히 확인했어요. 생각보다 중요한 부분이더라고요.

기타 실제 경험한 고려사항

- 전력 소비: 고성능 GPU 사용 시 전기료가 생각보다 올라가요

- 발열 관리: 긴 시간 사용하면 노트북이 뜨거워져서 쿨링팬이 계속 돌아가요

- 성능 한계: 클라우드 서비스 대비 응답 속도는 여전히 아쉬워요

결론

저희 팀에서 LM Studio를 도입한 지 몇 달이 지났는데, 정말 만족하고 있어요. 특히 비용과 보안 문제를 동시에 해결해준 점이 가장 큰 장점이었어요.

물론 클라우드 서비스 대비 성능이나 편의성 면에서는 아직 아쉬운 부분들이 있어요. 하지만 개인정보 보호가 중요한 프로젝트나 비용을 절약해야 하는 상황에서는 정말 훌륭한 대안이라고 생각해요.

혹시 저희와 비슷한 고민을 하고 계신 분들이 있다면 한번 시도해보시길 추천드려요. 동료분이 알려주신 덕분에 저희 팀의 AI 활용 방식이 완전히 바뀌었거든요.

궁금한 점이나 실제 사용 경험을 공유하고 싶으시면 언제든 댓글로 남겨주세요! 함께 이야기해보면 좋겠어요.